幫助中心

這里有最新的使用文檔和教程

Linux服務器遠程搭建的DeepSeek如何與Chatbox進行對接?

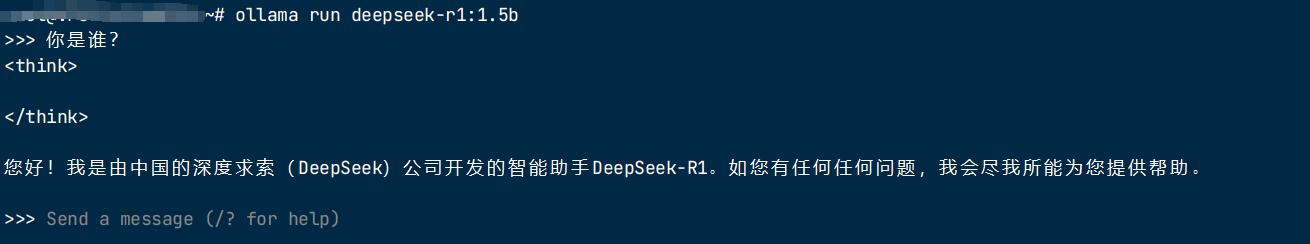

如果您在服務器通過Linux部署好了DeepSeek大模型,默認是只能在字符界面進行對話的。

如下圖:

為了獲得更好的交互體驗,可以安裝 Chatbox 作為 GUI 界面。

下載地址:https://chatboxai.app/zh#download

下載后直接雙擊后即可。

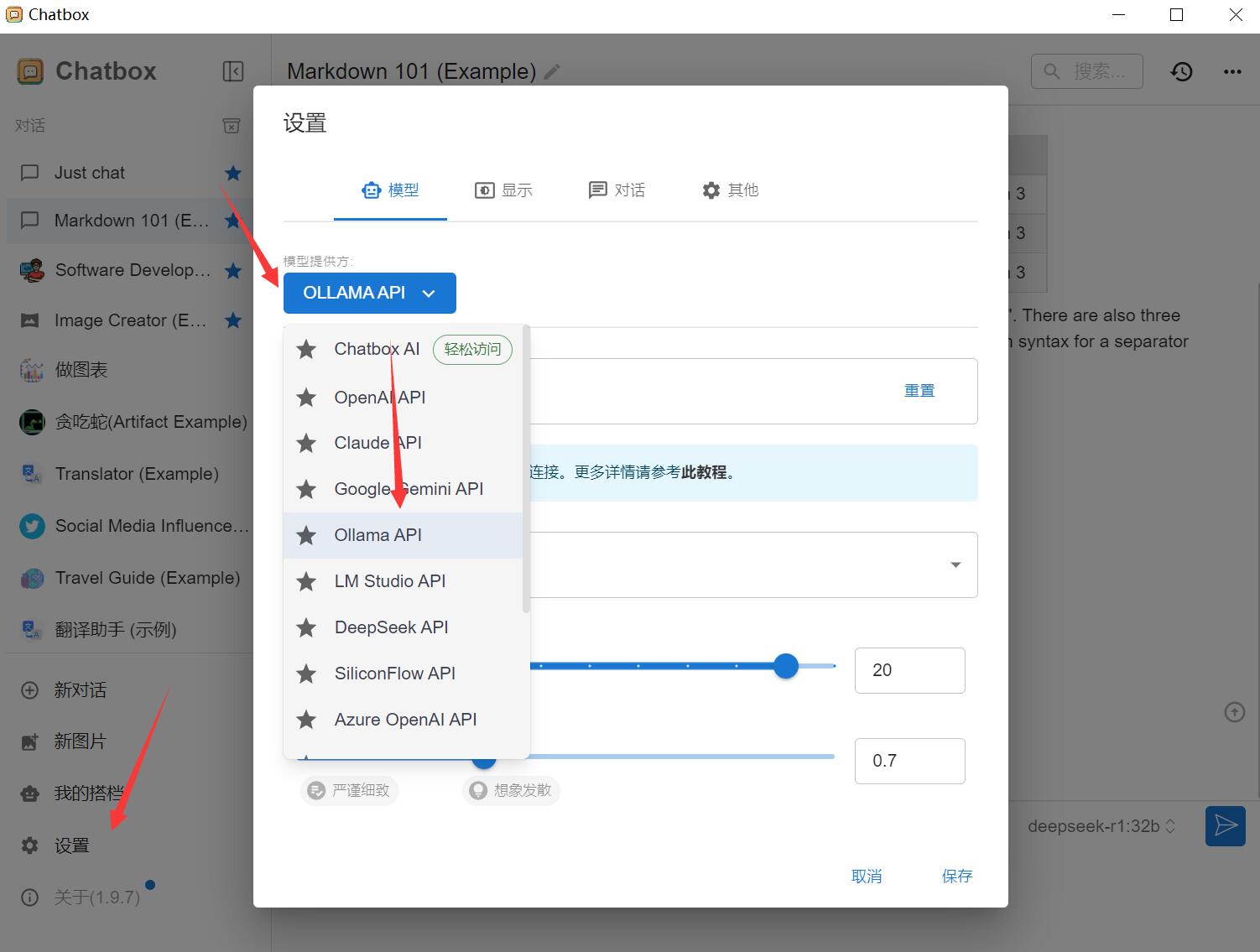

安裝完成后,進行以下配置:

在“配置 API 模型”選項中選擇 Ollama API。

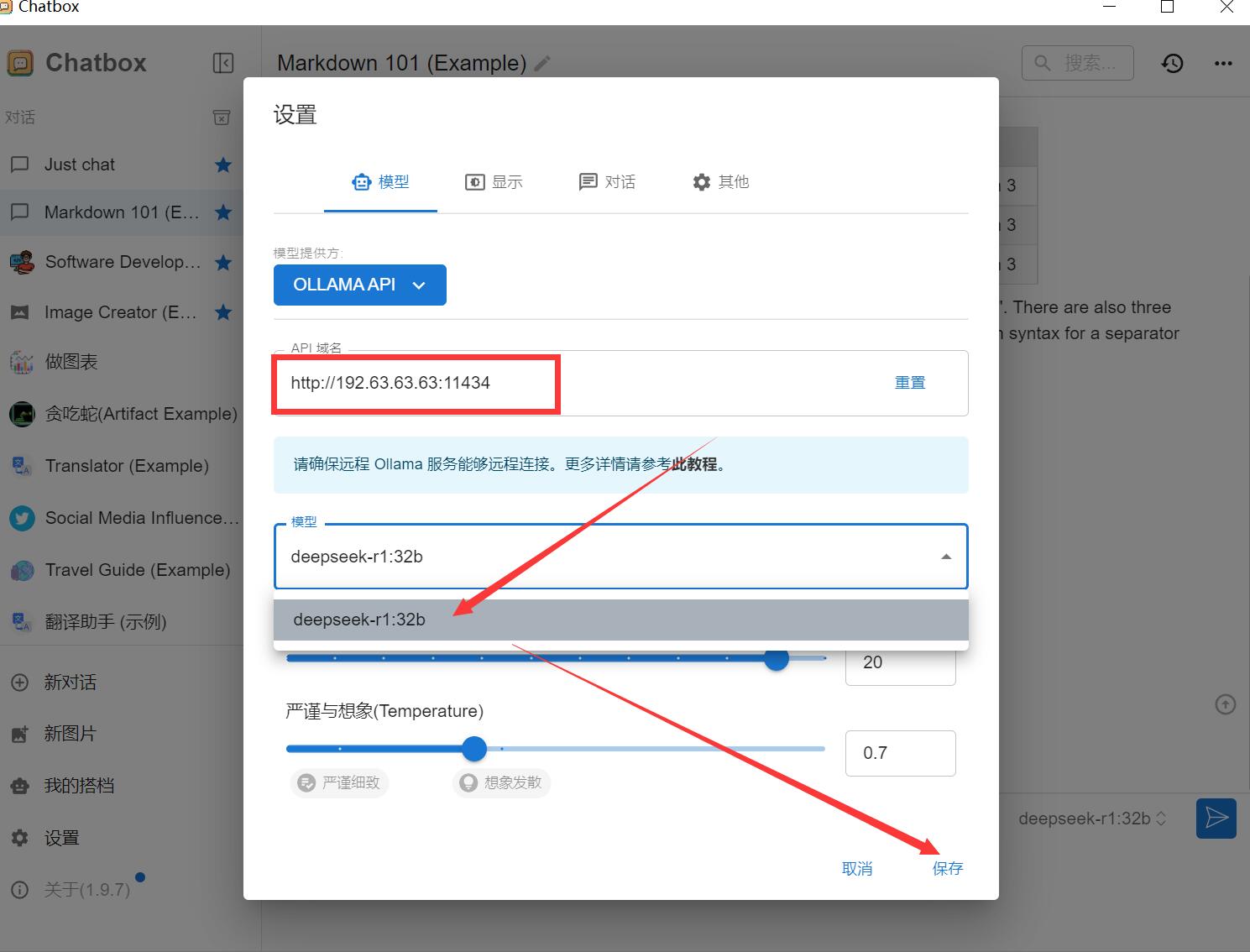

假如您的服務器IP是:192.63.63.63

那么這里設置 API 主機為:http://192.63.63.63:11434

選擇 DeepSeek R1 作為默認模型。

保存設置。

請注意:默認安裝好的 Ollama 服務是不對外開放的,如何配置遠程 Ollama 服務?

默認情況下,Ollama 服務僅在本地運行,不對外提供服務。要使 Ollama 服務能夠對外提供服務,你需要設置以下兩個環境變量:

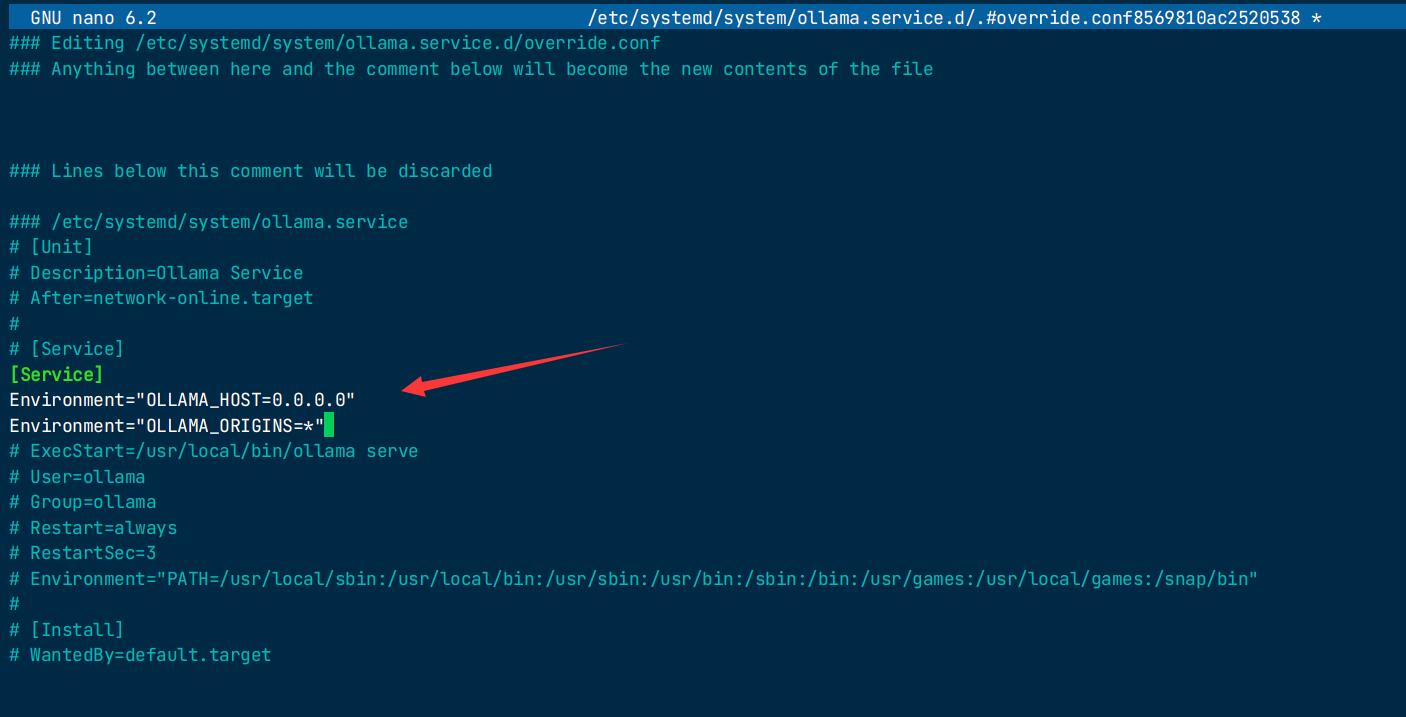

如果 Ollama 作為 systemd 服務運行,應使用 systemctl 設置環境變量:

-

調用

systemctl edit ollama.service編輯 systemd 服務配置。這將打開一個編輯器。 -

在 [Service] 部分下為每個環境變量添加一行 Environment:

[Service] Environment="OLLAMA_HOST=0.0.0.0" Environment="OLLAMA_ORIGINS=*" -

按Ctrl+X退出,再按Y保存并退出

-

-

重新加載 systemd 并重啟 Ollama:

systemctl daemon-reload systemctl restart ollama

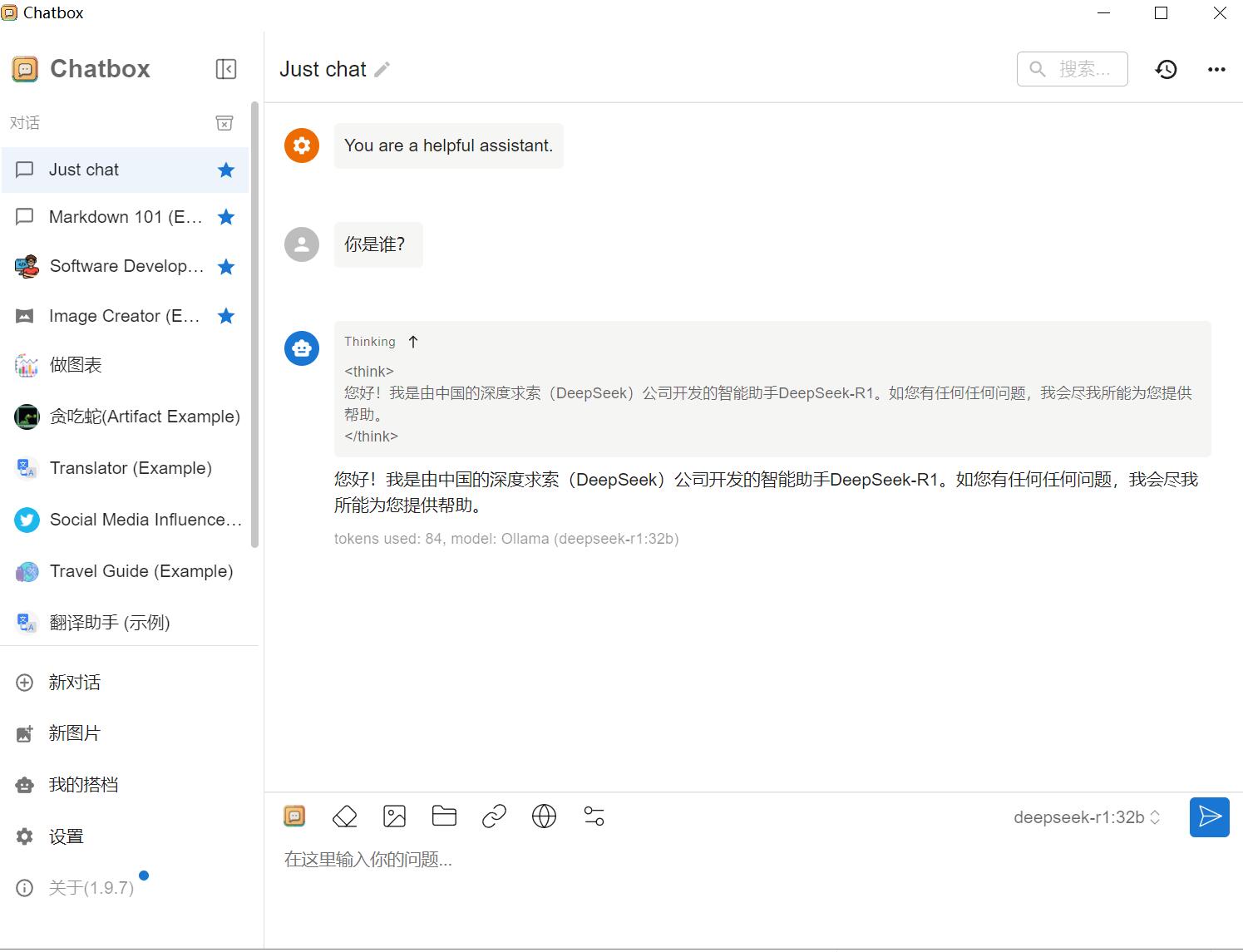

此時打開Chatbox ,選擇對接好的DeepSeek ,即可正常對話。