幫助中心

這里有最新的使用文檔和教程

Linux如何本地部署DeepSeek?GPU服務器如何部署DeepSeek?

一、DeepSeek R1 簡介

DeepSeek R1 是一款開源 AI 模型,其性能可與 OpenAI 的 GPT-4 和 Claude 3.5 Sonnet 等頂級模型媲美,尤其在數學、編程和推理等任務上表現出色。最重要的是,它是免費、私密的,可以在本地硬件上離線運行。

DeepSeek R1 提供多個參數規模的版本,從輕量級的 1.5b 參數模型到高性能的 671b 版本。它基于 Qwen 7B 架構的精簡優化版本,既保持強大性能,又具備更高的計算效率。

其主要亮點包括:

完全開源,可自由使用。

支持本地運行,無需依賴云服務器。

數據完全可控,確保隱私安全。

二、為什么選擇本地部署?

本地運行 AI 模型有以下優勢:

隱私保障:所有數據均存儲在本地,避免敏感信息泄露。

零額外成本:DeepSeek R1 免費運行,無需訂閱或額外費用。

完全控制:可以進行微調和本地優化,無需外部依賴。

三、硬件要求

部署 DeepSeek R1 需要一定的硬件資源,以下是不同模型對計算機,GPU的基本要求, 僅供參考:(如果本機Window系統部署去體驗,建議選擇1.5b 版本,比較快速。)

四、安裝步驟

首先準備一臺有GPU的服務器,安裝Ubuntu 22 系統(推薦安裝此系統)

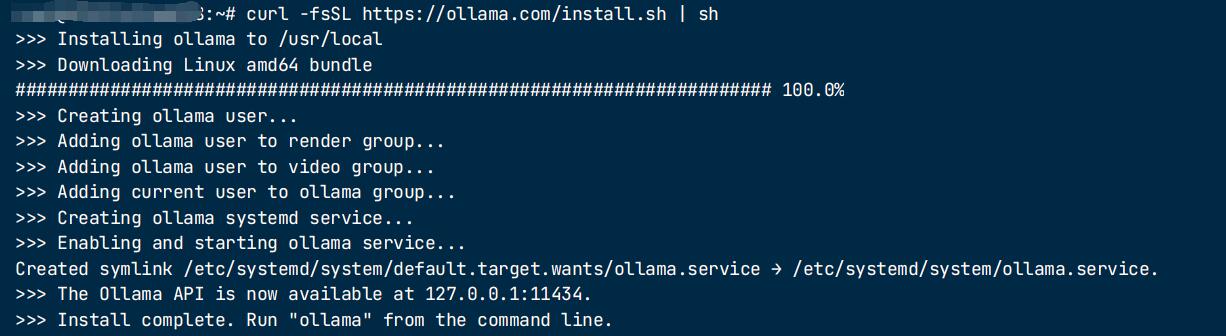

步驟 1:安裝 Ollama

Ollama 是一款本地 AI 運行工具,可幫助用戶輕松運行 DeepSeek R1。

下載地址:https://ollama.com/download/linux

直接執行 curl -fsSL https://ollama.com/install.sh | sh

安裝完成后,Ollama 提供了在終端直接運行 AI 模型的功能。

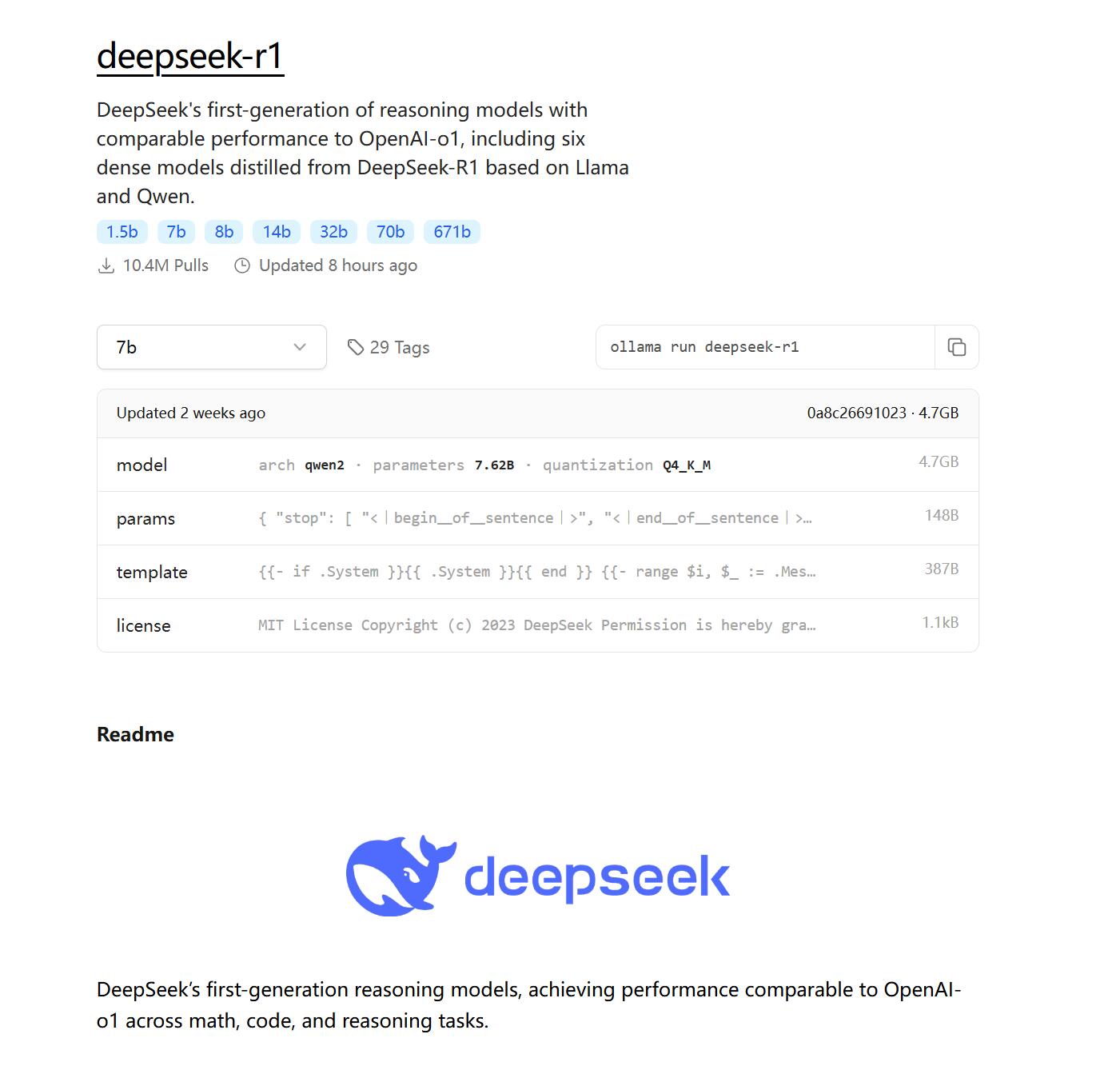

步驟 2:下載 DeepSeek R1 模型

下載地址:https://ollama.com/library/deepseek-r1

在終端中運行以下命令,根據你的硬件選擇合適的模型:

# 下載 1.5b 版本(適用于 CPU 及低配 GPU)

ollama run deepseek-r1:1.5b

# 下載 7b 版本

ollama run deepseek-r1:7b

# 下載 8b 版本

ollama run deepseek-r1:8b

# 下載 14b 版本

ollama run deepseek-r1:14b

# 下載 32b 版本

ollama run deepseek-r1:32b

# 下載 70b 版本

ollama run deepseek-r1:70b

# 下載 671b 版本(最高性能)

ollama run deepseek-r1:671b

安裝完成如下:

模型下載速度取決于網絡狀況,可能需要幾分鐘到幾十分鐘不等。

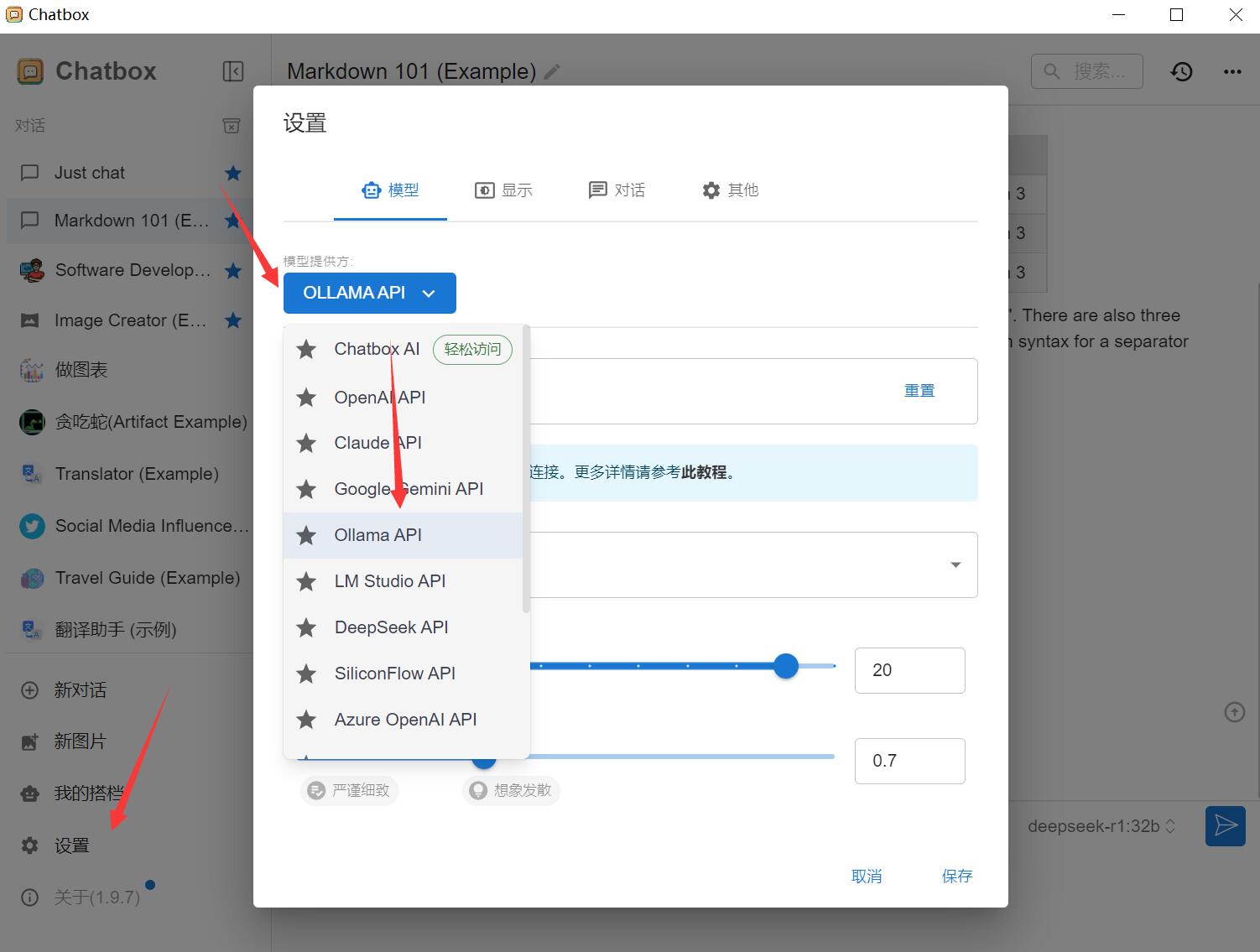

步驟 3:安裝 Chatbox(可選)

為了獲得更好的交互體驗,可以安裝 Chatbox 作為 GUI 界面。

下載地址:https://chatboxai.app/zh#download

下載后直接雙擊后即可。

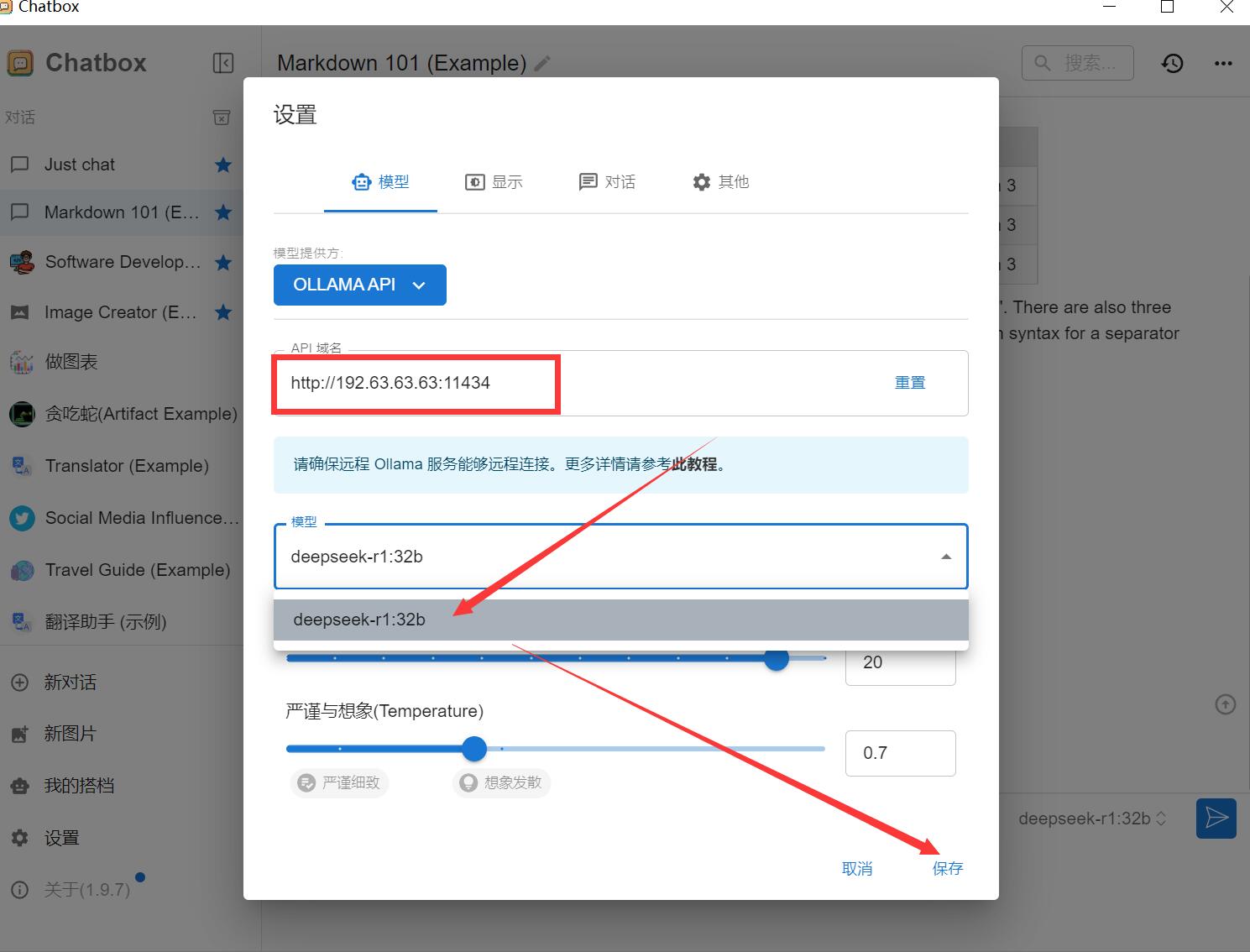

安裝完成后,進行以下配置:

在“配置 API 模型”選項中選擇 Ollama API。

假如您的服務器IP是:192.63.63.63

那么這里設置 API 主機為:http://192.63.63.63:11434

選擇 DeepSeek R1 作為默認模型。

保存設置。

請注意:默認安裝好的 Ollama 服務是不對外開放的,如何配置遠程 Ollama 服務?

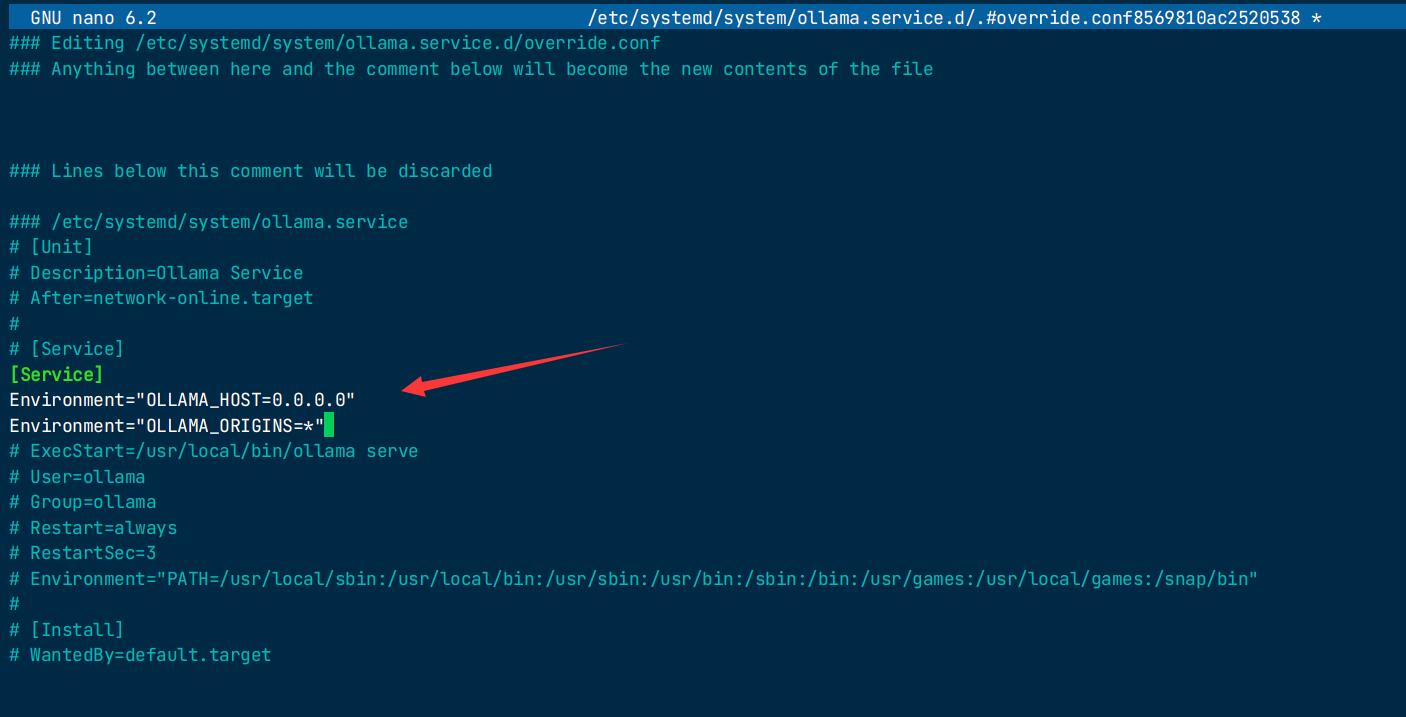

默認情況下,Ollama 服務僅在本地運行,不對外提供服務。要使 Ollama 服務能夠對外提供服務,你需要設置以下兩個環境變量:

如果 Ollama 作為 systemd 服務運行,應使用 systemctl 設置環境變量:

-

調用

systemctl edit ollama.service編輯 systemd 服務配置。這將打開一個編輯器。 -

在 [Service] 部分下為每個環境變量添加一行 Environment:

[Service] Environment="OLLAMA_HOST=0.0.0.0" Environment="OLLAMA_ORIGINS=*" -

按Ctrl+X退出,再按Y保存并退出

-

重新加載 systemd 并重啟 Ollama:

systemctl daemon-reload

systemctl restart ollama

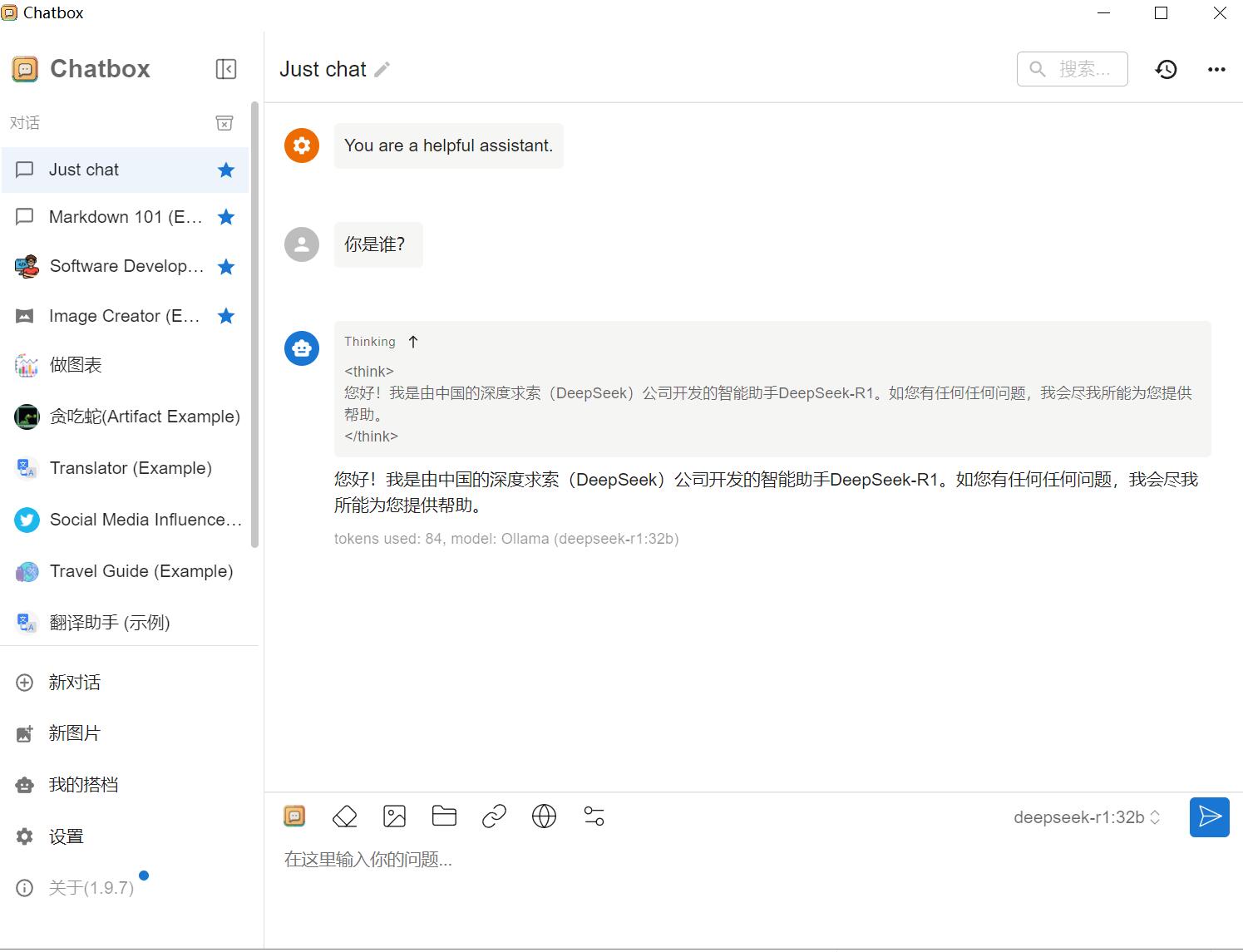

五、功能演示

此時打開Chatbox ,選擇對接好的DeepSeek ,即可正常對話。